Was meinen wir mit „Evidenz“? Einordnung für den Rettungsdienst

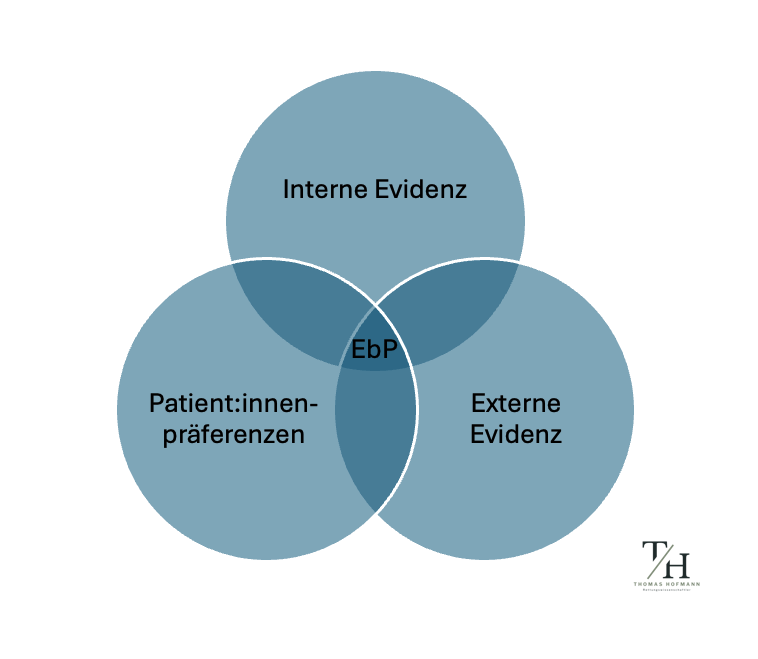

Im Rettungsdienst spricht man heute bewusst von evidenzbasierter Praxis (EBP) und nicht von evidenzbasierter Medizin. Das hat einen einfachen Grund: Entscheidungen im Einsatz umfassen mehr als medizinische Maßnahmen, sie berühren Organisation, Sicherheit, Kommunikation und Navigation in komplexen Lagen. EBP ist der weitere Rahmen und meint die informierte Verknüpfung von (a) externer Evidenz aus Forschung, (b) interner Evidenz aus Expertise und lokalen Daten und (c) den Präferenzen/Werten der betroffenen Person. Diese Trias ist seit den frühen Formulierungen des EBM-Kerns gut dokumentiert und gerade der Hinweis auf klinische Expertise und Patient:innenwerte verhindert, dass „Evidenz“ als reine Literaturreferenzierung missverstanden wird (Sackett et al., 1996). Abbildung 1 zeigt die Verknüpfung der drei Konzepte.

Begriffsarbeit: Warum „Evidenz“ mehr ist als externe Studienbefunde

Im allgemeinen Sprachgebrauch wird „Evidenz“ oft mit externer Evidenz gleichgesetzt, also dem, was in Studien gezeigt wurde. Das ist zu eng. Interne Evidenz umfasst das Erfahrungswissen der professionell Behandelnden, die operative Machbarkeit vor Ort, die lokalen Qualitäts- und Prozessdaten (z. B. Komplikationsraten, Zeiten, Ressourcen) und die Kompetenzen von Behandler:in und Team. Ohne diesen Bestandteil droht ein Praxisverständnis, in dem Studienergebnisse so gelesen werden, als würden sie automatisch auf jeden Einsatz passen. Das Gegenteil ist richtig: Studien liefern Anhaltspunkte, die erst durch Expertise und die Berücksichtigung von Kontext und Patient:innenpräferenzen zu einer belastbaren Entscheidung werden (Sackett et al., 1996).

Die verbreitete Engführung ist verständlich: Externe Evidenz lässt sich scheinbar klar zitieren, interne Evidenz muss organisiert, dokumentiert und reflektiert werden. Für EbP im Rettungsdienst ist es jedoch zentral, beide Wissensformen systematisch einzubeziehen und die Präferenzen der Betroffenen explizit zu erheben, soweit Lage und Einwilligungsfähigkeit es zulassen (Sackett et al., 1996).

EbP bedeutet damit nicht die Übernahme einzelner Studienbefunde, sondern die integrative Abwägung aus externer Evidenz, interner Evidenz und Patient:innenpräferenzen. Erst diese Verknüpfung führt zu belastbaren Entscheidungen; reine Literaturzitate oder Algorithmunsgläubigkeit genügen dem Evidenzbegriff nicht.

Evidenz als vorläufiges Wissen: Popper, Falsifikation und der Status von Theorien

Mit Karl Popper lässt sich wissenschaftliches Wissen als vorläufig verstehen. Theorien gelten so lange, bis sie widerlegt (falsifiziert) oder durch bessere ersetzt werden. Das bedeutet zweierlei. Erstens, „Evidenz“ ist kein Beweis im mathematischen Sinn, sondern der aktuelle beste Stand überprüfter bzw. überprüfbarer Aussagen. Zweitens, Fortschritt entsteht nicht durch Bestätigungsinflation, sondern durch kritische Tests, die eine Theorie scheitern lassen könnten. Für die Praxis folgt daraus, dass Evidenz Geltung beansprucht, aber keine Unantastbarkeit. Man handelt vernünftig und redlich, wenn man sie nutzt und wenn man ihre Vorläufigkeit kenntlich macht (Popper, 1973).

Diese Sicht passt zu einem nüchternen Umgang mit statistischen Ergebnissen. Ein signifikanter p-Wert zeigt keine „Wahrheit“ an. Er ist ein Indiz unter vielen und darf niemals isoliert von Effektgröße, Präzision und Kontext gelesen werden. Genau darauf weist auch die Stellungnahme der American Statistical Association hin: p-Werte quantifizieren weder die Wahrscheinlichkeit, dass eine Hypothese wahr ist, noch die Größe eines Effekts; sie sind nur ein Teil der Evidenz (Wasserstein & Lazar, 2016).

In diesem Sinn ist Evidenz kein Beweis, sondern der gegenwärtig beste Stand überprüfter Aussagen, solange, bis bessere Aussagen auftauchen.

Warum eine einzelne Studie keine Evidenz ist

Einzelstudien sind Bausteine, nicht die Evidenz selbst. Das hängt mit mehreren Punkten zusammen:

- Erstens sind Fehlschlüsse in der Literatur nicht selten. Ioannidis hat plausibel gemacht, warum veröffentlichte Befunde systematisch überschätzt sein können (geringe Power, Bias, multiple Tests, Publikationsanreize). Deshalb ist es wahrscheinlicher, dass einzelne „positive“ Ergebnisse nicht Bestand haben, wenn Replikationen fehlen (Ioannidis, 2005).

- Zweitens verlangt gute Praxis Kohärenz aus mehreren Quellen. Systematische Reviews, Replikationsstudien, konsistente Effekte in unterschiedlichen Populationen, mechanistische und theoretische Plausibilität und – wo möglich – patient:innenrelevante Outcomes (oder im Rettungsdienst eher Outputs) statt bloßer Surrogatparameter. Surrogate (z. B. Laborwerte, Prozesszeiten) können nützlich sein, sind aber kein Ersatz für reale klinische Endpunkte wie Mortalität, Morbidität, Funktion oder Lebensqualität (Fleming & DeMets, 1996; Howick, Chalmers, Lind, et al., 2011).

- Drittens entscheidet die Übertragbarkeit: Was in einem RCT funktioniert, passt nicht automatisch in jede Versorgungssituation. Rothwell hat die externe Validität als eigenständigen Prüfstein herausgearbeitet: Für wen und wo gilt ein Ergebnis tatsächlich? Für den Rettungsdienst mit seinen heterogenen Settings ist diese Frage besonders kritisch (Rothwell, 2005).

Studien kritisch prüfen, bevor sie zur externen Evidenz werden

Wenn Einzelstudien Bausteine sind, stellt sich die Frage: Wie prüft man ihre Qualität? Ein tragfähiger Weg ist die kritische Beurteilung mit etablierten Instrumenten. Für den Praxisgebrauch sind die Critical Appraisal Tools des Joanna Briggs Institute (JBI) besonders zugänglich. Sie helfen, Verzerrungsrisiken (Bias), Relevanz und Ergebnisqualität studientypspezifisch zu beurteilen, von randomisierten Studien über Beobachtungsstudien bis zu qualitativen Designs. Es gibt aber auch noch andere Tools, die man nutzen kann:

- Joanna Briggs Institute: https://jbi.global/critical-appraisal-tools

- Centre for Evidence-Based Medicine: https://www.cebm.ox.ac.uk/resources/ebm-tools/critical-appraisal-tools

- Critical Appraisal Skills Programme: https://casp-uk.net

Denn nicht alles, was publiziert ist, hat die Qualität, die klinische Praxis zu verändern. Nichtdestotrotz, darf man auch nicht überkritisch sein. Keine Studie ist perfekt, vielmehr geht es darum aus den Ergebnissen verschiedener, gut gemachter Studien, ein konsistentes Gesamtbild zu entwickeln.

Was zusätzlich zum Evidenzverständnis gehört

Die OCEBM-Levels of Evidence bieten eine praxistaugliche Orientierung für Evidenzhierarchien, sind aber ausdrücklich kein Automatismus. Die Oxford-Dokumente betonen, dass jede Hierarchie Urteilskraft und Kontextprüfung braucht. Wichtiger als die Stufe allein ist, wie gut die Evidenz zur Frage passt und wie robust sie ist (Howick, Chalmers, Glasziou, et al., 2011).

Signifikanz ist nicht Relevanz. Neben p-Werten zählen Effektgröße und Konfidenzintervall und die klinische Relevanz (z. B. Number needed to treat – NNT). Wer Evidenz nutzt, fragt: Wie groß ist der wahrscheinliche Nutzen/Schaden? Und, ob dies das für diese Population relevant ist, denn Signifikanz ist nicht Relevanz. (Wasserstein & Lazar, 2016)

„Evidenz“ ist noch keine Empfehlung. Erst die Abwägung aus externer Evidenz, interner Evidenz und Patient:innenpräferenzen führt zu einer begründeten Entscheidung. GRADE macht diesen Übergang transparent, indem es die Sicherheit der Evidenz von der Stärke (und Richtung) der Empfehlung trennt (Guyatt et al., 2011)

Interne Evidenz entsteht nicht von allein. Sie braucht Dateninfrastruktur (z. B. einfache Qualitätsindikatoren, Clinical Governance), Reflexionsräume (z. B. M&M-Konferenzen) und die Bereitschaft, Entscheidungen transparent zu dokumentieren, samt Unsicherheiten. So wächst ein lokales Wissensnetz, das externe Evidenz ergänzt und kalibriert.

Fazit

„Evidenz“ ist mehrschichtig. Sie besteht nicht aus einzelnen Studien, und schon gar nicht aus isolierten p-Werten. Sie ist ein Netzwerk aus Befunden, deren Qualität und Relevanz geprüft werden müssen, und sie bleibt vorläufig im besten Sinn, offen für Korrektur, wenn besseres Wissen entsteht. Für die evidenzbasierte Praxis im Rettungsdienst heißt das: Man nimmt externe Evidenz ernst, prüft sie mit kritischen Werkzeugen, achtet auf Übertragbarkeit, bevorzugt patient:innenrelevante Endpunkte, und verknüpft all das mit interner Evidenz und Patient:innenpräferenzen. Erst diese Verbindung verdient den Namen Evidenz im starken, praxisrelevanten Sinn.

Quellen

Fleming, T. R., & DeMets, D. L. (1996). Surrogate End Points in Clinical Trials: Are We Being Misled? Annals of Internal Medicine, 125(7), 605–613. https://doi.org/10.7326/0003-4819-125-7-199610010-00011

Guyatt, G., Oxman, A. D., Akl, E. A., Kunz, R., Vist, G., Brozek, J., Norris, S., Falck-Ytter, Y., Glasziou, P., & deBeer, H. (2011). GRADE guidelines: 1. Introduction—GRADE evidence profiles and summary of findings tables. Journal of Clinical Epidemiology, 64(4), 383–394. https://doi.org/10.1016/j.jclinepi.2010.04.026

Howick, J., Chalmers, I., Glasziou, P., Greenhalgh, T., Heneghan, C., Liberati, A., Moschetti, I., Phillips; Bob, & Thornton, H. (2011). The 2011 Oxford CEBM Levels of Evidence: Introductory Document. http://www.cebm.net/index.aspx?o=5653

Ioannidis, J. P. A. (2005). Why Most Published Research Findings Are False. PLoS Medicine, 2(8), e124. https://doi.org/10.1371/journal.pmed.0020124

Popper, K. (1973). Logik der Forschung (5th ed.). J. C. B. Mohr (Paul Siebeck).

Rothwell, P. M. (2005). External validity of randomised controlled trials: “To whom do the results of this trial apply?” The Lancet, 365(9453), 82–93. https://doi.org/10.1016/S0140-6736(04)17670-8

Sackett, D. L., Rosenberg, W. M. C., Gray, J. A. M., Haynes, R. B., & Richardson, W. S. (1996). Evidence based medicine: what it is and what it isn’t. BMJ, 312(7023), 71–72. https://doi.org/10.1136/bmj.312.7023.71

Wasserstein, R. L., & Lazar, N. A. (2016). The ASA’s Statement on p-Values: Context, Process, and Purpose. In American Statistician (Vol. 70, Issue 2, pp. 129–133). American Statistical Association. https://doi.org/10.1080/00031305.2016.1154108